77 % новых кластерных систем и суперкомпьютеров используют InfiniBand

17.11.2017

Как мы уже неоднократно отмечали, одной из важнейших частей любого суперкомпьютера или кластера является система межузловых соединений. Именно от неё зависит то, насколько эффективно будут распараллеливаться ресурсы, ведь медленная сеть легко может свести на нет все преимущества самых мощных процессоров и ускорителей. Сегодня Ethernet претендует на эту роль весьма активно благодаря развитию новых стандартов и достижению скоростей уровня 200 Гбит/с. Но другая технология, исторически раньше укоренившаяся в суперкомпьютерной отрасли, InfiniBand, похоже, не собирается сдавать позиции.

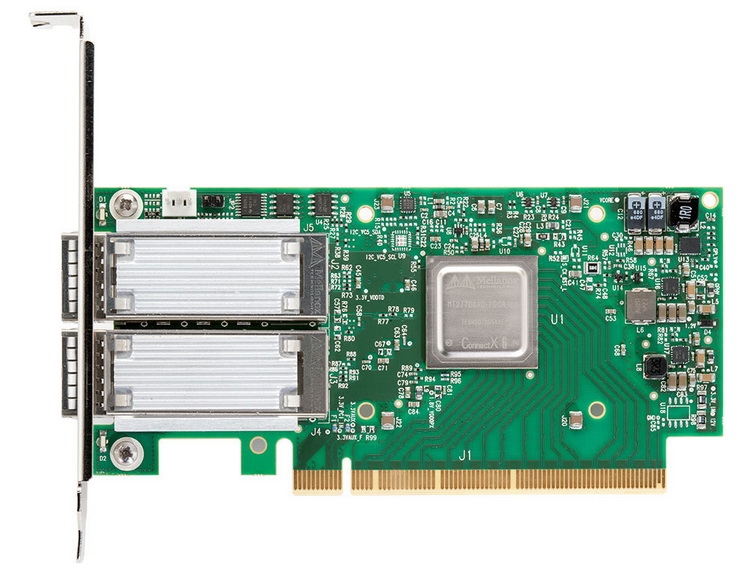

Mellanox Innova-2: новейшее достижение компании в области Ethernet

Говорим InfiniBand, подразумеваем Mellanox. Именно эта компания является самым активным разработчиком соответствующих устройств на рынке InfiniBand. Такое название, как ConnectX, знакомо любому, кто когда-либо интересовался тематикой высокоскоростных межсерверных соединений. Компания опубликовала последнюю статистику, согласно которой, 77 % всех суперкомпьютеров, вошедших в список TOP500 последними, в период с июня по ноябрь текущего года, используют именно InfiniBand. Таких систем в шесть раз больше, нежели применяющих сети собственной разработки и в 15 раз больше, нежели платформ, объединённых стандартом Ethernet.

А вот последние модели адаптеров InfiniBand используют уже новый чипсет ConnectX-6

Всего на долю InfiniBand приходится 60 % всех систем в списке, из этих 60 % две системы входят в пятёрку наиболее производительных суперкомпьютеров в мире. Как считают представители Mellanox, это закономерно, поскольку InfiniBand обладает рядом преимуществ перед Ethernet. Как минимум, данный протокол с самого начала разрабатывался, как предназначенный именно для использования в системах класса HPC, поэтому его создатели сконцентрировались на достижении не только высокой пропускной способности, но и минимизации задержек. Впрочем, Mellanox не отказывается от Ethernet. Напротив, на выставке-конференции SC17 она представила ряд интересных решений, включая новейшие «умные» ускорители на базе связки чипов ConnectX-5 и Xilinx Kintex UltraScale.

Источник: http://servernews.ru/961639

| Вернуться в Новости |